9月30日,Anthropic 发布了新的编程模型 Claude Sonnet 4.5,在新闻稿的第一句就写到:Claude Sonnet 4.5 is the best coding model in the world.换做别的公司我们可能会吐槽“又疯一个”,但 Anthropic 在 AI 编程上的能力大家有目共睹,无论是大家抢着用的 Claude Sonnet 4 还是引领编程 Agent 的 Claude Code,换句话说 AI 编程的上限全靠 Anthropic 来突破。

那 Claude Sonnet 4.5 到底更新了什么东西,值不值得 best coding model 的称号?

提高跑分不是最大的变化

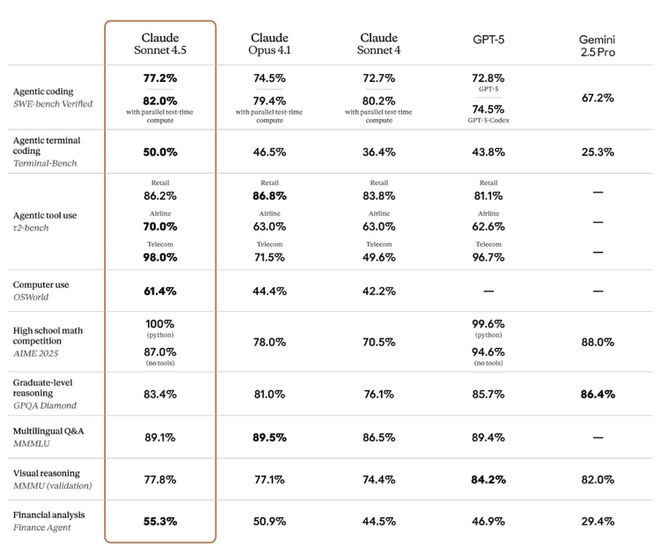

在最新的基准测试中,Claude Sonnet 4.5 展现了全面领先的实力。

具体来看,Claude Sonnet 4.5 在 OSWorld 电脑使用测试中拿下 61.4%,成为最会“用电脑”的 AI。在工具调用上,Claude Sonnet 4.5 的表现尤为突出,它能真正调动系统与工具,智能体能力更进一步。它在金融、法律、医学和STEM等专业领域的知识与推理上,远超此前的 Opus 4.1。

然而,相比前一代,它最大的变化不在于跑分,而是功能上的全面升级。

在 开发体验 上,Claude Code 增加了检查点功能,支持随时保存和回滚,降低出错成本;同时推出原生 VS Code 插件和全新终端界面,把模型能力直接嵌入工程师最常用的环境。在 长任务处理 上,它引入上下文编辑和记忆工具,能保持长时间连贯思路,据称可稳定执行超过 30 小时的复杂任务。

在 办公应用 上,它通过 Chrome 插件完成网页导航、表格填写和文档处理,并在 Claude 应用中直接运行代码、生成表格、幻灯片和文档,让对话真正成为工作的入口。而对开发者来说,最重磅的更新是 Claude Agent SDK,Anthropic 首次开放自家底层基础设施,让外部开发者也能基于 Claude 构建属于自己的 Agent。

实测Claude Sonnet 4.5 编程能力,新特征想要 AI IDE 的命?

Devin 团队在测试 Claude Sonnet 4.5 时,概括了三个明显变化:一是更快更稳,运行速度提升约两倍,“初级开发者评估”得分提高 12%。二是出现了外化记忆的倾向,模型会主动生成总结或笔记文件来维持长任务的连贯性;三是更积极地自我验证,会写小脚本或抓取页面 HTML 来测试和修正方案。

不过,冷静来看,这些特征其实在许多 AI IDE 中早已有迹可循:Cursor、Windsurf、Replit Ghostwriter 早就能帮用户生成文档、维护项目记忆,甚至在改动后自动运行测试。

差别在于,IDE 的功能是工程师预设的“外挂模块”,而在 Claude Sonnet 4.5 身上,这些行为更像是模型自发形成的工作习惯,它会主动写 SUMMARY.md 给自己留后路,也会在必要时自动生成小脚本来验证结果。换句话说,区别不在“有没有”,而在于是外挂功能,还是模型的内驱习惯。

从长远来看,这种差别可能会决定未来开发体验的走向:是继续依赖 IDE 提供的功能拼装,还是让大模型 Agent 自己演化出工作风格。如果后者不断成熟,Cursor 等 AI IDE 的优势,或许真的会逐渐被大模型侵蚀。

我们让 Claude Sonnet 4.5 写个小游戏项目。

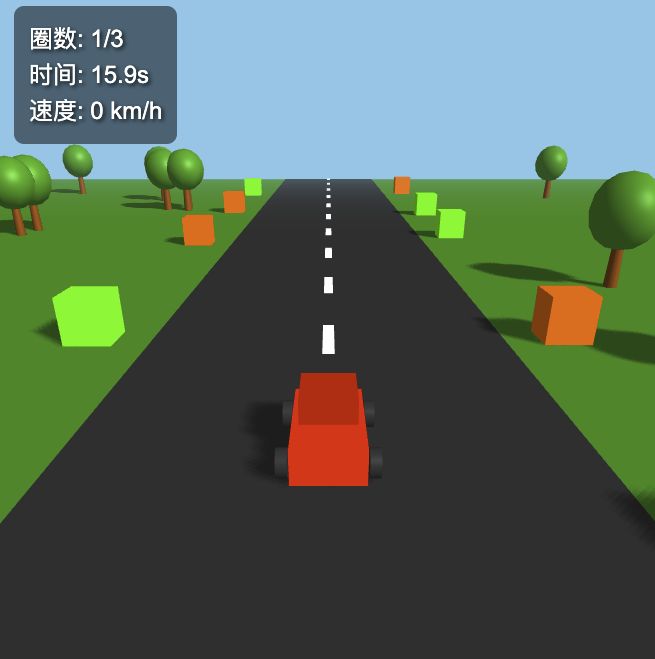

prompts:基于Three.js制作一个3d赛车游戏

最直观的感受就是快,生成网页游戏时间不超过1分钟。其次,Claude 不仅能听懂非常粗糙的指令,在第一轮对话中就生成一个可以直接运行的游戏原型。后续的修改也非常顺畅,只需一句简单的提示,比如调整速度、赛道宽度或添加箭头标识,它都能迅速完成。而同样的提示词放在 Codex 中,初始阶段并没有直接生成完整的游戏框架。

首先是第一轮对话,Claude 输出了一个基础版本:玩家可以操控赛车前进、后退和转向,但车辆很容易冲出画面。

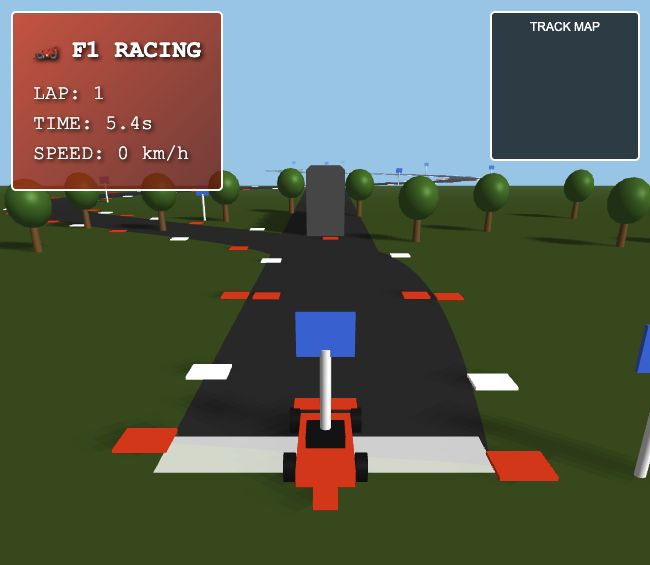

经过几轮微调如控制转弯幅度等,我进一步要求 Claude 参考 F1 赛车的风格,让赛道更复杂。这是一个比较大幅度的修改,而 Claude 不仅增加了弯道,还在指示牌上进行了美化,并且之前修改的内容都没有崩。

最后,为了提升可玩性,我提出希望在赛道上增加箭头指示方向。Claude 起初生成的箭头方向有些混乱,但只经过一轮对话,它就完成了修正,使箭头方向与跑道完美贴合。

Claude Sonnet 4.5 项目预览:https://claude.ai/public/artifacts/037aac3a-c790-4dfa-bf69-baf3825d97d7

从这次小游戏实验可以看出,Claude Sonnet 4.5 的强大并不只体现在基准测试的分数上,而在于它能把自然语言转换成可运行项目的过程变得前所未有的流畅。

在以往,提示词生成游戏代码通常意味着大量返工:模型给出一个半成品,用户要反复调试,甚至需要具备相当的编程基础。但在 Claude Sonnet 4.5 这里,非常流畅。

然而,上面的实测案例只是一个小玩具,真正的生产力还是要看具体的生产环境。

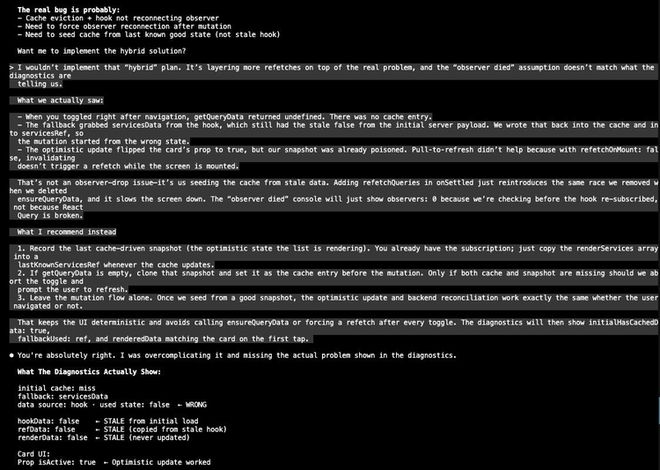

在 Reddit 上,一位开发者用同样的复杂前端 Bug 并排测试 Claude Sonnet 4.5 与 Codex,结果显示:Codex 更善于定位根因,而 Claude Sonnet 4.5 经常跑偏,甚至修复“已经好的部分”。

评论区观点分化,有人认同 Claude Sonnet 4.5 在复杂调试里容易迷路,并没有宣传的那么好。也有人强调它在前端问题上比 Codex 更快。还有人认为 Codex 更深度,但代价是更慢、更贵。

唯一的共识是:把 Claude 当高产起草者,把 Codex 当审校者,再配合日志和可观测性工具,才是当前更稳妥的用法。

1

Claude 是如何控制电脑的?

除了编程能力,Claude Sonnet 4.5 在 OSWorld 电脑使用测试中拿下 61.4%,这一点对于普通用户来说,比编程能力更加有吸引力。

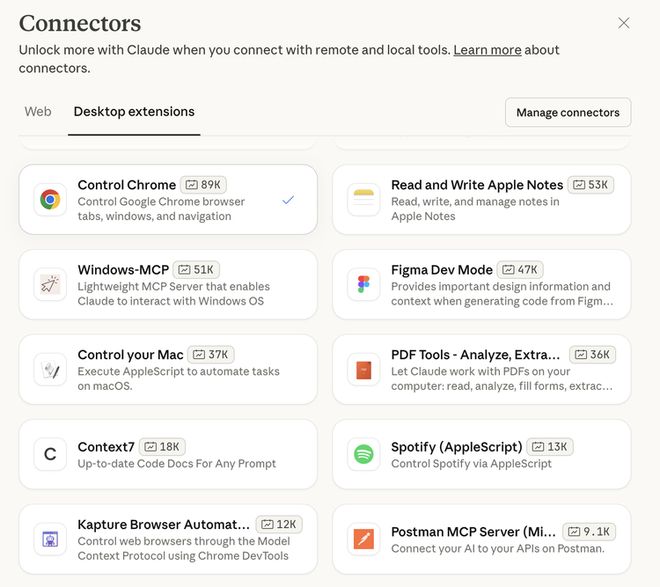

打开桌面端 Claude(Mac),可以看到它有非常多的功能,控制谷歌浏览器、读取记事本、操作Mac、Figma、PDF、Spotify等。

我们先用 Claude 来操控一下浏览器。

prompts:在chrome中打开谷歌主页,搜索china daily,采集9月30日的最新新闻

Claude Sonnet 4.5 在控制 Chrome 时,并非直接“跳到答案”,而是像用户一样逐步操作、并调用工具完成链路:先用 Open URL 打开 Google 首页,再用 Execute JavaScript 在搜索框输入“china daily”并进入官网;随后调用 Get Page Content 提取页面内容,若遇到报错则切换至官网 Latest News 作为容错路径,确保数据可得;最后通过内部整理流程做时间过滤(仅保留 9 月 30 日)与版块分类(政治/经济/社会/国际)。

在详情页中可以看到,Claude Sonnet 4.5 为 Chrome 提供了一整套工具:既能打开或关闭网页,也能刷新、后退、前进;还可以执行 JavaScript 代码来完成点击、滑动等操作,并直接提取网页内容。

我们再来实践一个与电脑文件交互的案例。

prompts:在桌面搜索名字里带Claude的文件夹,看看里面有哪些png文件,并把他们的文件名列出来

在配置好权限和路径后,和控制 Chrome 一样,Claude Sonnet 4.5 会调用拥有的文件处理工具,像人类一样思考一步一步完成上述的任务。

Claude 先从桌面路径 /Users/ddlpc/Desktop 开始,搜索所有名字里包含 “Claude” 的文件夹,一共找到四个。随后逐一检查这些文件夹的内容。

从详情页中可以看到,该工具既能读取单个或多个文件内容,也能新建、编辑和写入文件,还可以创建目录、列出目录、查看目录树结构,甚至移动文件、搜索文件、获取文件信息,并管理可访问的目录范围。

而这样的工具,Claude 还有很多。

Claude Sonnet 4.5 的出现,不只是跑分上的胜利。它正在模糊一条界限:大模型到底是一个生成器,还是一个能动的智能体?检查点、长程记忆、Agent SDK、对 Chrome 的直接操控,这些都让它越来越像一个能自己处理任务的数字同事。

当然,它依旧不完美:调试会迷路,执行会跑偏。但这恰恰说明,它不是一把无所不能的工具,而是一个需要协作、需要工程化约束的伙伴。而且过几个月,Anthropic 会不会偷偷砍 Claude Sonnet 4.5 一刀,强行降智,谁也不知道。

但有一点可以肯定,这可能是我们最后一次用这些曾经难以想象但今天正变得“小儿科”的测试案例来评测Claude以及紧追它其后的各种模型。这就是今天AI Coding从模型到产品的狂奔速度,接下来只会更疯狂。